Segundo o último relatório das Nações Unidas sobre a guerra civil na Líbia, o ano que termina viu pela primeira vez um sistema de armas autónomo, um robô assassino, matar alguém. No futuro, poderemos lembrá-lo como o ponto de partida de uma nova corrida armamentista que poderá nos prejudicar gravemente.

Nos últimos dias (de 13 a 17 de dezembro) La Convenção das Nações Unidas sobre Certas Armas Convencionais reunidos sobre o assunto, como acontece a cada cinco anos. Desde 1983, esta assembleia optou por limitar algumas armas cruéis, como as minas antipessoal. Desta vez, ele discutiu uma possível proibição dessas armas autônomas. E não chegou a um consenso para limitá-los.

Pode ter sido um erro catastrófico.

Os sistemas de armas autônomos são robôs assassinos. Ao longo deste post você sempre me ouvirá chamá-los assim: robôs assassinos. Porque é isso que eu sou. Sistemas com armas que podem funcionar sozinhos. Sistemas feitos para a guerra, para matar pessoas. Os governos mundiais estão a investir fortemente nesta tendência.

Por outro lado, obviamente, as organizações humanitárias (uma delas, Stop The Killer Robots, que você encontra aqui) dedicam-se a pedir regras e proibições ao desenvolvimento destas armas. E eles se saem bem. Se não limitarmos o uso de armas autônomas, tudo terminará muito mal. As tecnologias disruptivas neste domínio poderão desestabilizar todas as estratégias militares, aumentando o risco de ataques preventivos. Incluindo os químicos, biológicos e nucleares.

Dado o ritmo de desenvolvimento dos robôs assassinos, a reunião da ONU que acabou de terminar pode ter sido uma das últimas ocasiões para evitar uma nova corrida armamentista. Ou o último.

Existem quatro perigos que parecem óbvios para qualquer pessoa quando se trata de sistemas robóticos assassinos.

Primeiro problema de robôs assassinos: identificação.

as armas autônomas SEMPRE serão capazes de distinguir entre um soldado hostil e uma criança com uma arma de brinquedo? A diferença entre um único erro humano (que também é possível) e a configuração incorreta de um algoritmo pode levar o problema a uma escala incrível. Um especialista em armas autônomo chamado Paulo Scharre usa uma metáfora: a de uma metralhadora defeituosa que continua a disparar mesmo quando você tira o dedo do gatilho. E atire até a munição acabar, porque é só uma máquina. Ele não sabe que está cometendo um erro.

O que quer que digam, a inteligência artificial ainda não tem moral própria (e ele provavelmente nunca terá, ele nunca será capaz de aprender).

O problema não é só isso até mesmo uma IA está errada, por exemplo, quando reconhece a asma como um factor o que reduz o risco de pneumonia, ou quando identifica pessoas de cor como gorila. Só que quando comete um erro, quem o criou não sabe por que errou e não sabe como corrigi-lo. Por esta razão acredito ser impossível que robôs assassinos possam se desenvolver com qualquer tipo de critério “moral”.

Segundo problema com robôs assassinos: proliferação de baixo custo.

As forças armadas que estão a desenvolver armas autónomas assumem que serão capazes de as conter e controlar. Você já ouviu uma ideia mais estúpida do que essa? Se há uma coisa que a história da tecnologia bélica nos ensina, apenas uma coisa, é que as armas se espalham. Também neste caso era muito previsível.

O que aconteceu no passado com o Kashinkov, um rifle de assalto que se tornou tão acessível que acaba nas mãos de qualquer pessoa, pode se repetir para os robôs assassinos. As pressões do mercado podem levar à criação de armas autónomas que sejam eficazes, baratas e virtualmente impossíveis de parar. Acima de tudo: generalizado. Nas mãos de governos, cavalos malucos, crime organizado ou grupos terroristas.

Pode já ter acontecido. O Cargu-2, feito por uma empresa de defesa turca, é um cruzamento entre um drone e uma bomba. Possui inteligência artificial para encontrar e rastrear alvos. É um robô assassino e já atuou de forma autônoma no teatro da guerra civil na Líbia para atacar pessoas.

Terceiro problema dos robôs assassinos: proliferação de alta tecnologia.

Se pensarmos então nos riscos “de ponta” chegamos ao Zenit. As nações poderiam competir para desenvolver versões cada vez mais devastadoras de armas autónomas, incluindo aquelas capazes de montar armas químicas, biológicas, radiológicas e nucleares . Os perigos morais da escalada da letalidade das armas seriam amplificados pela escalada do uso de armas.

Claro, esses robôs assassinos provavelmente virão com robôs caros controladores éticos projetado para minimizar danos colaterais, perseguindo o mito do ataque “cirúrgico”. Coisas boas apenas para a opinião pública, em suma. A verdade é que as armas autónomas irão alterar até a mais banal análise de custo-benefício que se faz antes de planear uma guerra. Serão dados de risco mortal, para serem lançados com menos preocupação.

As guerras assimétricas travadas no terreno por nações sem tecnologias concorrentes se tornarão mais comuns. Uma instabilidade amplamente disseminada.

Quarto e último problema: as leis da guerra

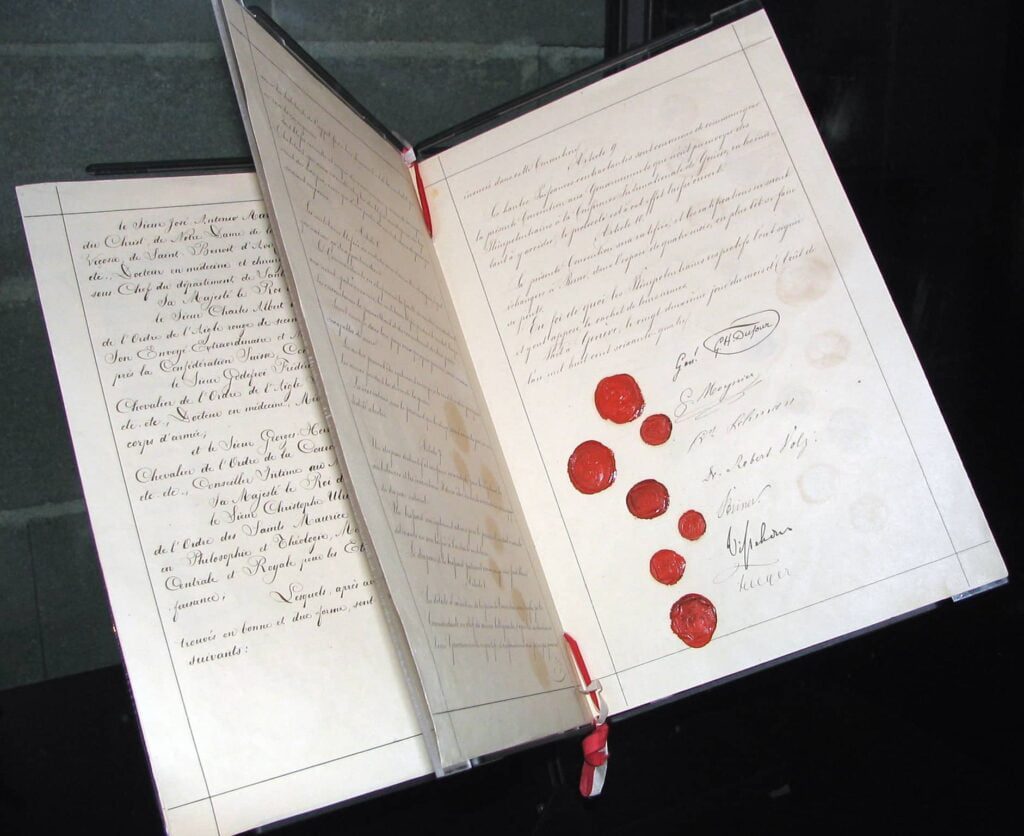

Os robôs assassinos (se proliferarem é uma certeza) minarão o último paliativo da humanidade contra crimes de guerra e atrocidades: as leis internacionais da guerra. Estas leis, codificadas em tratados a partir do primeiro Convenção de Genebra, eles são a linha tênue que separa a guerra de algo ainda pior que eu dificilmente posso imaginar.

As leis da guerra são fundamentais, porque também impõem responsabilidades àqueles que travam uma guerra. Slobodan Milosevic era o presidente de um país e tinha que responder pelos seus atos. Ele foi julgado no Tribunal Penal Internacional das Nações Unidas para a ex-Iugoslávia e ele tinha que responder pelo que fez.

E agora? A culpa é de um robô assassino que comete crimes de guerra? Quem está sendo processado? A arma? O soldado? Os comandantes do soldado? A empresa que fabricou a arma? As ONG e os especialistas em direito internacional temem que as armas autónomas conduzam a um sério lacuna de responsabilidade .

Terá que ser provado que um militar cometeu um crime ao utilizar uma arma autónoma. Para isso, será necessário provar que o soldado cometeu um ato culposo e também teve a intenção específica de fazê-lo. Uma dinâmica bastante complicada, num mundo de robôs assassinos.

Um mundo de robôs assassinos é um mundo sem regras que eles impõem controle humano significativo em armas. É um mundo onde crimes de guerra serão cometidos sem criminosos de guerra a serem responsabilizados. A estrutura das leis da guerra, junto com seu valor dissuasor, ficará consideravelmente enfraquecida.

Uma nova corrida armamentista global

Imagine que todos podem usar toda a força que quiserem, quando quiserem. Com menos consequências para qualquer pessoa. Imagine um planeta onde militares nacionais e internacionais, grupos insurgentes e terroristas possam desdobrar uma força letal teoricamente ilimitada com risco teoricamente zero em momentos e locais de sua escolha, sem nenhuma responsabilidade legal resultante.